- Warum wir?

- Funktionen

White Label

Für SaaS-Anbieter & Agenturen

Stellen Sie Ihren Kunden unsere komplette Analytics-Suite zur Verfügung, direkt in Ihrer eigenen Benutzeroberfläche und mit Ihrem eigenen Branding. Entdecken Sie Analytics-as-a-Service und White Label Analytics. Großer Nutzen, minimaler Aufwand.

- Preise

- White Label

- Erfolgsgeschichten

- RessourcenWissensdatenbankErste Schritte

-

Häufig gestellte Fragen

-

Alles über die Funktionen

- So installieren Sie den Tracking-Code

-

Leitfäden

-

Integration mit anderen Plattformen

-

Rechtliches, Datenschutz & Zertifikate

- White Label Analytics

- Glossar

- Partnerprogramm

- Kontaktieren Sie unser Team

- Allgemein

- Wie kann ich TWIPLA auf meiner Webseite installieren?

- Was sollte ich in meine Datenschutzrichtlinie aufnehmen?

- Ist TWIPLA DSGVO/CCPA-konform?

- Was passiert, wenn ich bereits die Standalone-Version der App (oder eines Ihrer Plugins) verwendet habe und zu einem anderen Plugin wechseln möchte?

- Bietet TWIPLA ein Partnerprogramm an?

- Kann TWIPLA Google Analytics ersetzen?

- Kann TWIPLA Hotjar ersetzen?

- Kann TWIPLA Analytify ersetzen?

- Kann TWIPLA Mouseflow ersetzen?

- Warum erhalte ich immer wieder die Fehlermeldung, dass der Tracking-Code nicht erfolgreich installiert wurde?

- Das Snippet funktioniert nicht in der Kopfzeile in meinem Webseiten-Baukasten. Wie kann ich dieses Problem beheben?

- Verwalten Sie Ihr Konto

- Verwalten Sie Ihre Webseiten

- Kann ich mehrere Webseiten mit demselben Konto betreiben?

- Wie kann ich Websites hinzufügen oder entfernen?

- Wie kann ich Mitwirkende für eine Website hinzufügen oder entfernen?

- Wie kann ich eine Einladung zur Mitarbeit auf einer Website annehmen oder ablehnen?

- Wie kann ich mich als Beitragszahler von einer Website abmelden?

- Premium-Pläne & Abrechnung

- Welcher Abonnementplan ist der beste für meine Webseite?

- Wird der Premium-Plan allen meinen Webseiten zugewiesen?

- Läuft der kostenlose Plan aus?

- Was geschieht, wenn die Höchstzahl der in meinem Plan enthaltenen Besuche erreicht ist?

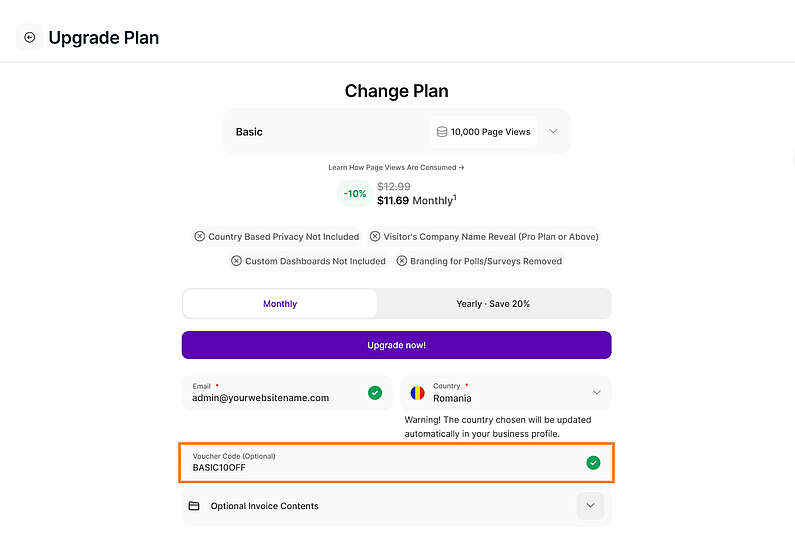

- Wie wende ich einen Promo-Code an, wenn ich einen Premium-Plan kaufe?

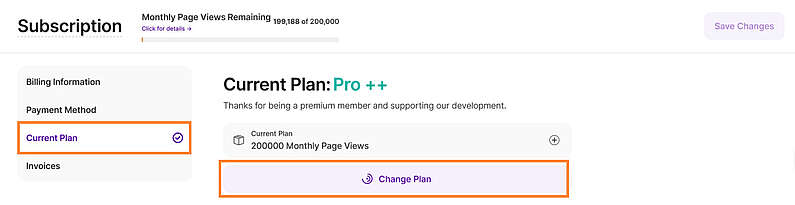

- Wie kann ich meinen Abonnementplan ändern?

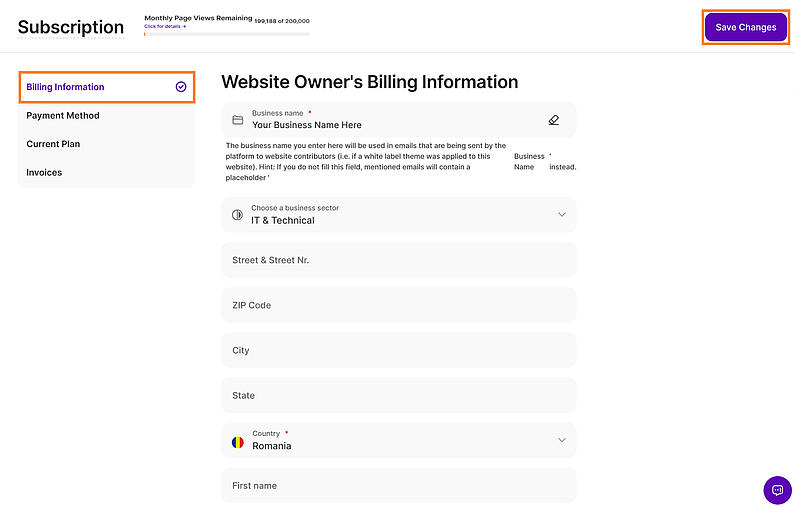

- Wie kann ich meine Rechnungsdaten aktualisieren?

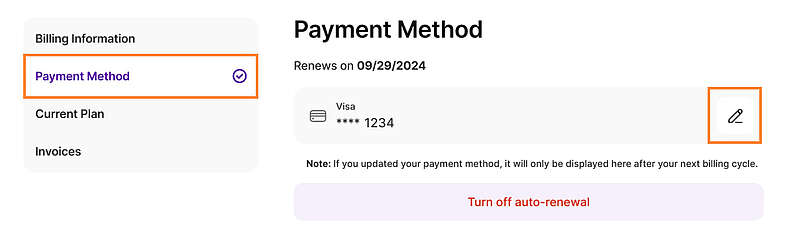

- Wie kann ich Kreditkartendaten hinzufügen oder ändern?

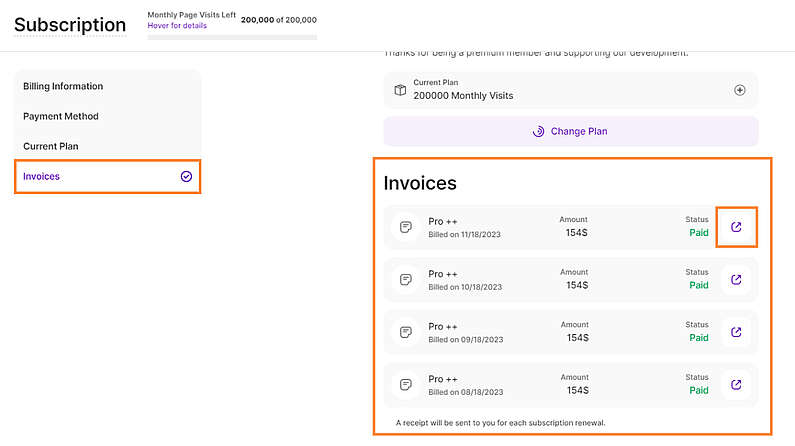

- Wie kann ich meine Rechnung herunterladen?

- Wie verwalte ich meine Rechnungen für alle meine Webseiten?

- Funktionalitäten

- Wie erhalte ich mit meinem Mobiltelefon einfachen Zugang zum TWIPLA?

- Wo liegen die Grenzen der Funktion Sitzungsaufzeichnungen?

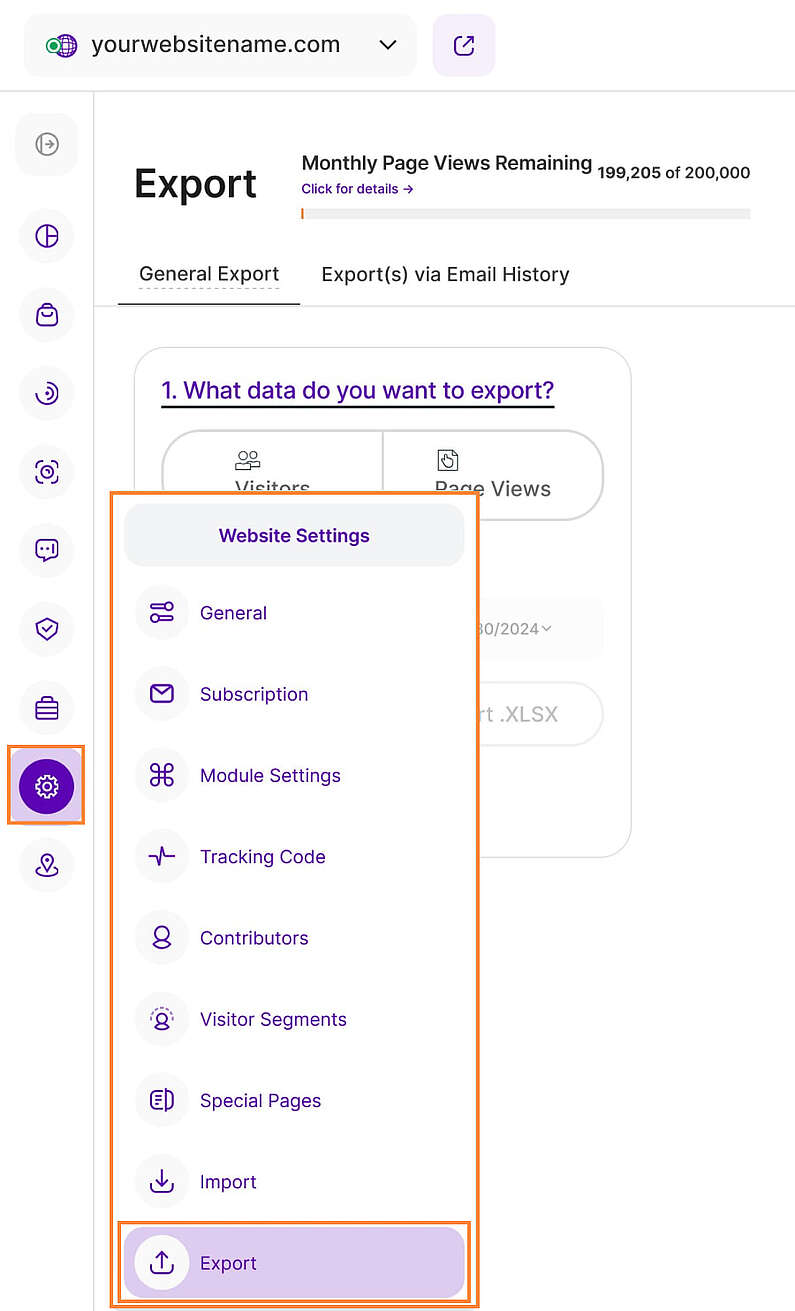

- Wie exportiere ich Daten für meine Webseite?

- Wie kann ich meine URL-Kampagnen verfolgen?

- Wie präzise lässt sich der Standort meiner Besucher bestimmen?

- Kann ich die Besucher verfolgen, die auf eine bestimmte Schaltfläche auf meiner Webseite klicken?

- Wie kann ich die Option "Ignoriere (eigene) Besuche für das IP-Tracking" in Safari aktiviert lassen?

- Warum erhalte ich Besuche aus Ländern, zu denen meine Webseite keinen Bezug hat?

- Kann ich Besucher aus einem bestimmten Land vom Besuch meiner Webseite ausschließen?

- Kann ich die Unternehmensdaten oder die E-Mail-Adresse meiner Besucher sehen?

- Warum gibt es mehrere IP-Adressen für ein und denselben Besucher?

- Warum gibt es für einige der Sitzungen keinen Hinweis?

- Wie kann ich den Traffic auf meiner Webseite erhöhen?

- Warum ist die Schriftart bei der Wiedergabe meiner Sitzungsaufzeichnung anders?

- Webseiten-Einstellungen

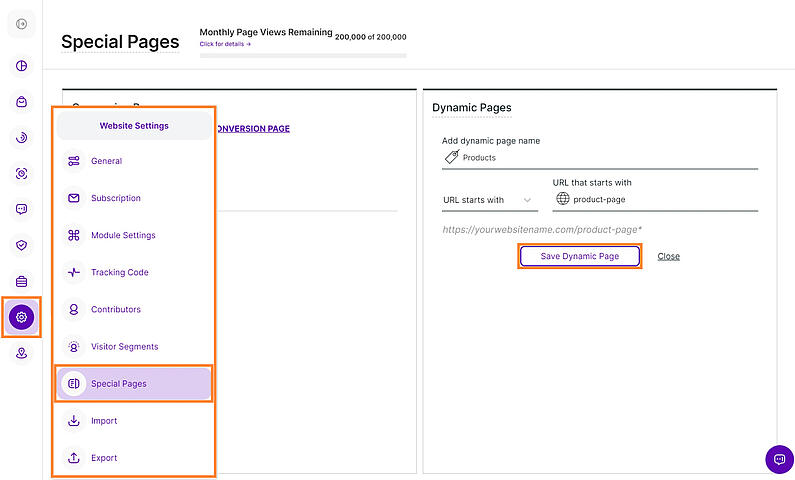

- Was ist eine dynamische Seite und wie stelle ich sie ein?

- Was ist eine Konversionsseite und wie stelle ich sie ein?

- Wie kann ich meine eigenen Besuche oder eine IP ignorieren?

- Wie kann ich die IP-Adressen meiner Besucher anonymisieren?

- Wie ändere ich die E-Mail-Adresse, an die ich Berichte erhalten möchte?

- Wie kann ich eine Domain/Subdomain meiner Webseite auf die Whitelist setzen?

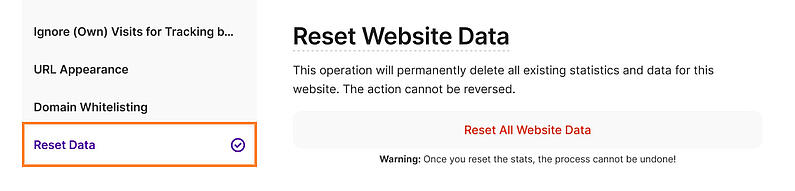

- Wie setze ich Daten für eine Webseite zurück?

- GA-Import

- Wann ist es empfehlenswert Daten aus GA zu importieren?

- Kann ich Daten aus meinem Google Analytics-Konto mehrfach auf dieselbe Webseite importieren?

- Kann ich Daten von 2 verschiedenen GA-Konten in dasselbe TWIPLA-Konto importieren?

- Wann kann ich die importierten Daten sehen?

- Wirken sich die importierten Daten auf mein Besuchslimit aus, das ich für mein TWIPLA-Paket habe?

- Brauche ich einen Premium-Tarif, um Zugang zu dieser Funktion zu haben?

- Was passiert, wenn ich meine Daten zurücksetze, nachdem ich sie von GA importiert habe?

- Wie kann ich den Importvorgang stoppen?

- Häufig gestellte Fragen

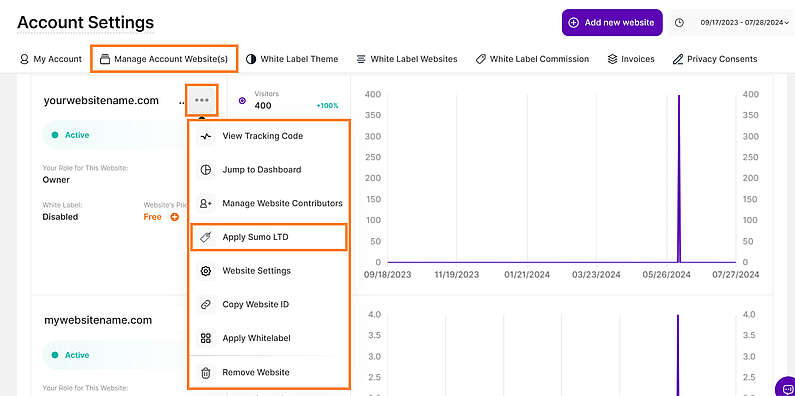

- Wie kann ich AppSumo LTD auf mein Konto anwenden?

- Haben Sie irgendwelche laufenden Bug Bounty Programme? Bieten Sie Belohnungen an, wenn wir Ihnen Sicherheitslücken melden?

- Wie erfasst TWIPLA IP-Adressen unter "Light Privacy", wenn TWIPLA keine Cookies verwendet?

- Benötige ich bei der Datenschutzstufe "Light Privacy" eine Einwilligung und ein Banner?

- Wenn das Datenschutz-Center anzeigt, dass alle Datenschutzsstufen keine Cookies verwenden, bedeutet das dann, dass mehr Webstatistiken erfasst werden, als wenn eine Analyse mit Cookie-Tracking durchgeführt wird?

- Kann ich mit TWIPLA Werbeblocker umgehen?

- Wie erkennt man Bots?

- Wie kann ich die Zahlungsmethode aktualisieren?

- Werden Schlüsselwörter oder Suchbegriffe verfolgt?

- Wie kann ich das TWIPLA-Abonnement kündigen?

- Sie können die Antwort auf Ihre Frage nicht finden?

Wie kann ich TWIPLA auf meiner Webseite installieren?

TWIPLA kann leicht zu jeder Art von Webseite hinzugefügt werden. Sie können entweder eines unserer speziellen Plugins/Module (je nach Plattform) installieren oder einfach einen Tracking-Code in die <body> und </body> Tags Ihres Quellcodes einbetten.

Detaillierte Informationen zum Hinzufügen Ihres Tracking-Codes oder zur Installation der Plugin-App auf jeder Art von Webseite finden Sie in unserer Installationsanleitung hier. Bitte zögern Sie nicht, sich bei Bedarf direkt an unseren Support zu wenden!

Was sollte ich in meine Datenschutzrichtlinie aufnehmen?

Wir haben eine Vorlage erstellt, um unsere Kunden bei der Einhaltung der Datenschutzgesetze zu unterstützen und alle Informationen über persönliche Daten leicht verständlich und kontrollierbar zu machen. Auf dieser Seite finden Sie für weitere Details.

Ist TWIPLA DSGVO/CCPA-konform?

Es ist toll, ein so großes Interesse an DSGVO und anderen Datenschutzinformationen zu sehen! Wir schätzen unsere Kunden sehr und wissen, dass Sie über die DSGVO besorgt sind. Aber, keine Sorge - TWIPLA ist zu 100% auf die DSGVO vorbereitet.

Hier finden Sie unsere DSGVO-Verpflichtung - eine Seite darüber, was es mit der DSGVO auf sich hat und wie wir personenbezogene Daten schützen und die Vorgaben einhalten.

Da wir als Analyselösung der Auftragsverarbeiter für Webseitenbetreiber sind, haben wir auch eine Vereinbarung zur Datenverarbeitung in den Einstellungen der App, die Sie jederzeit unterschreiben und herunterladen können.

Wir haben Datenschutzmodi vorbereitet, die Benachrichtigungseinstellungen geändert und alle Dokumente leicht auffindbar und lesbar gestaltet.

Wenn Sie sich fragen, was Sie in Ihre Datenschutzrichtlinien einfügen sollen, wenn Sie unsere App verwenden, haben wir auch hierfür die Lösung. Hier finden Sie was Sie in Ihre Datenschutzrichtlinie aufnehmen sollten sowie die Liste der Cookies und weitere Informationen.

Was passiert, wenn ich bereits die Standalone-Version der App (oder eines Ihrer Plugins) verwendet habe und zu einem anderen Plugin wechseln möchte?

Wenn Sie den Tracking-Code bereits in den Quellcode Ihrer Webseite eingebettet oder eines unserer Plugins für Plattformen wie Drupal, Typo3, Weebly, WordPress usw. verwendet haben und zu einer anderen Plattform (für die wir ebenfalls ein Plugin/eine Erweiterung anbieten) wechseln möchten, gehen Sie folgendermaßen vor:

- Installieren Sie das Plugin für die neue Plattform.

- Melden Sie sich mit demselben TWIPLA-Konto an.

Bitte beachten Sie, dass, wenn sich die Domain während des Transfers von einem Webseiten-Baukasten zu einem anderen ändert, das Einloggen in unser Plugin für die neue Webseite diese zu Ihrem TWIPLA-Konto mit dem entsprechenden Tracking-Code hinzufügt und neu beginnt.

Auch wenn Sie mehrere Webseiten in Ihrem Konto haben, die auf verschiedenen Webseiten-Baukasten-Plattformen erstellt wurden, können Sie unsere Plugins verwenden, um die Statistiken einzeln vom Backend jeder Plattform aus zu überprüfen. Alternativ können Sie auch alle Webseiten verwalten und die Statistiken für jede einzelne an einem Ort einsehen, indem Sie sich mit Ihrem TWIPLA-Konto hier anmelden.

Bietet TWIPLA ein Partnerprogramm an?

Wir freuen uns, dass Sie sich für das Partnerprogramm interessieren.

Empfehlen Sie Kunden an TWIPLA und verdienen Sie 20% Provision auf jede ihrer Zahlungen! Erstellen Sie ein Konto und beginnen Sie Geld zu verdienen.

Mehr über unser Programm erfahren Sie hier.

Kann TWIPLA Google Analytics ersetzen?

Ja, TWIPLA bietet Statistiken und sammelt die Besuche und Besucher Ihrer Webseite.

Mit TWIPLA vergessen Sie all die unübersichtlichen Diagramme, Dropdowns oder unübersichtliche überwältigenden Diagramme. Sehen Sie sich auf eine einfach Weise an, wie Ihre Webseite mit einer benutzerfreundlichen Schnittstelle und leicht zu verstehenden Diagrammen funktioniert!

Ein weiterer Hinweis, der uns sehr am Herzen liegt: Wir arbeiten nicht mit Werbetreibenden zusammen, und alle Daten gehören Ihnen.

Kann TWIPLA Hotjar ersetzen?

Ja, TWIPLA bietet verhaltensbezogene Funktionen wie Sitzungsaufzeichnungen, Heatmaps, Trichter und vieles mehr. Erfahren Sie mehr über alle diese Funktionen, indem Sie einfach auf unserer Webseite zu den entsprechenden Funktionen navigieren.

Hier können Sie sich alle Erklärungsvideos zur App ansehen.

Kann TWIPLA Analytify ersetzen?

Ja. Im Gegensatz zu Analytify, das eine Zusammenfassung von Google Analytics ist, hat TWIPLA seine eigene Tracking-Infrastruktur. Das hat den Vorteil, dass wir viele Funktionen entwickeln können, welche andere Plattformen, die auf Google Analytics basieren, nicht unterstützen. Zum Beispiel können wir zeigen, was jeder Besucher auf individueller Basis tut.

Warum erhalte ich immer wieder die Fehlermeldung, dass der Tracking-Code nicht erfolgreich installiert wurde?

Solange die Besuche getrackt werden, brauchen Sie sich keine Sorgen machen!

Höchstwahrscheinlich fehlt ein Leerzeichen oder ein zusätzliches Zeichen im Code. Unser Tracking-Code-Checker kann den Tracking-Code evtl. nicht in der Form finden, in der er ihn erwartet. Eine andere Möglichkeit wäre, dass der Quellcode ist nicht öffentlich sichtbar ist (aufgrund eines iFrames, in dem sich Ihre Webseite befindet, oder einer Weiterleitung von einer Domäne zu einer anderen) und der Tracking-Code-Checker kann ihn daher nicht finden kann.

Seien Sie versichert, dass dies leicht zu beheben ist. Kontaktieren Sie uns einfach und wir überprüfen für Sie die Installation und setzen Sie auf "Erfolgreich installiert", wenn alles richtig funktioniert.

Das Snippet funktioniert nicht in der Kopfzeile in meinem Webseiten-Baukasten. Wie kann ich dieses Problem beheben?

Wenn Sie auf ein Problem stoßen, bei dem ein Skript-Snippet nicht funktioniert, wenn es im Header Ihres Webseiten-Baukastens platziert ist, liegt das wahrscheinlich daran, dass das Skript ausgeführt wird, bevor das Document Object Model (DOM) vollständig geladen ist. Dies kann zu einem Fehler wie "Uncaught TypeError: b is undefined" führen.

Um dieses Problem zu lösen, können Sie das Skript im Header platzieren, aber stellen Sie bitte sicher, dass es erst ausgeführt wird, wenn das DOM vollständig geladen ist. Hier ist ein Code-Snippet, das dies bewerkstelligt:

<script> document.addEventListener("DOMContentLoaded", function () { (function (v, i, s, a, t) { v[t] = v[t] || function () { (v[t].v = v[t].v || []).push(arguments); }; if (!v._visaSettings) { v._visaSettings = {}; } v._visaSettings[a] = { v: '1.0', s: a, a: '1', t: t }; var b = i.getElementsByTagName('body')[0]; var p = i.createElement('script'); p.defer = 1; p.async = 1; p.src = s + '?s=' + a; b.appendChild(p); })(window, document, '//app-worker.visitor-analytics.io/main.js', 'INSERT-HERE-YOUR-WEBSITE-ID', 'va'); }); </script>Dieser Code stellt sicher, dass das Skript in der Kopfzeile erst geladen wird, wenn das DOM vollständig geladen ist, und verhindert so den vorherigen Fehler.

Für die meisten Webseiten ist es jedoch empfehlenswert, Skripte am unteren Ende des Textkörpers einzufügen, da so derartige Probleme in der Regel ganz vermieden werden können.

Wie erstellt man ein TWIPLA-Konto?

Greifen Sie auf alle Tools zu, die Sie als Webseiten-Betreiber benötigen, um Ihre Statistiken und Besucher in einer umfassenden Anwendung zu verfolgen und zu analysieren. Erleben Sie die Funktionen mit unserem kostenlosen Plan für The All-in-One Analytics App, indem Sie zu diesem Link und dann auf Registrieren klicken.

Warum kann ich mich nicht bei meinem TWIPLA-Konto anmelden?

Es könnte einige Faktoren geben, die Schwierigkeiten beim Einloggen verursachen. Um sich erfolgreich einzuloggen, vergewissern Sie sich bitte, dass:

- Sie bereits ein TWIPLA-Konto besitzen. Falls nicht, können Sie hier eines erstellen.

- die E-Mail-Adresse und das Passwort, das Sie eingegeben haben, korrekt sind. Sie können im Anmeldefenster ein neues Passwort anfordern oder zurücksetzen, indem Sie auf "Passwort vergessen?" klicken.

- Ihr Konto innerhalb von 10 Tagen nach der Erstellung bestätigt wird. Nach der Erstellung Ihres Kontos wird sofort eine Bestätigungs-E-Mail verschickt. In den ersten 10 Tagen können Sie sich jedoch auch ohne Bestätigung anmelden. Nach 3, 7 und 10 Tagen wird nochmals eine Erinnerung verschickt.

- Eine weitere Methode zur Bestätigung des Kontos wäre, zu versuchen, sich anzumelden. Wenn die Fehlermeldung "Konto wurde nicht bestätigt" erscheint, wird Ihnen die Option "Senden Sie die Bestätigungs-E-Mail erneut" angezeigt. Dadurch erhalten Sie einen neuen und gültigen Link zur Aktivierung Ihres Kontos.

Hinweis: Vergewissern Sie sich, dass Sie die zuletzt erhaltene Erinnerung zur Bestätigung verwenden, da frühere Erinnerungen, sofern vorhanden, nicht mehr gültig sind.

Falls nötig, zögern Sie nicht direkt unseren Support zu kontaktieren.

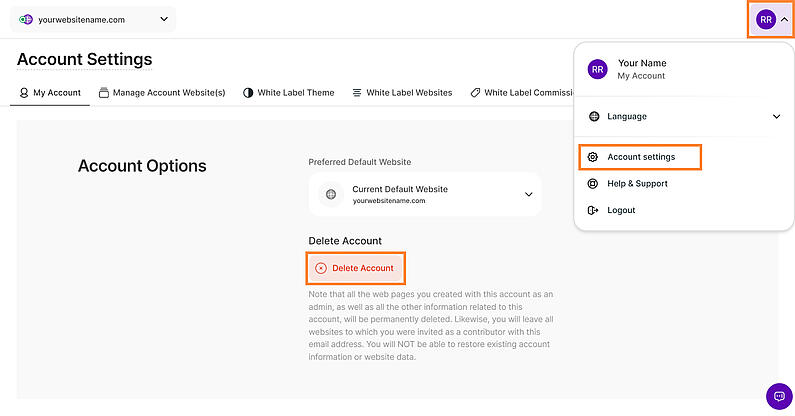

Bevor Sie mit der Löschung fortfahren, beachten Sie bitte, dass gelöschte Konten den Zugang zu allen Analysen verlieren, die mit Ihrem Konto verknüpft sind, und dass die Löschung unwiderruflich ist.

Wenn Sie sich sicher sind, dass Sie Ihr TWIPLA-Konto löschen möchten, hängt der Vorgang von Ihrem Abonnement ab. Beginnen Sie damit, alle Abonnements zu kündigen und alle Webseiten von Ihrem Konto zu entfernen.

Sobald diese Schritte abgeschlossen sind, folgen Sie den nachstehenden Anweisungen, um Ihr TWIPLA-Konto zu löschen:

- Loggen Sie sich in Ihr TWIPLA-Konto ein.

- Navigieren Sie zu den Kontoeinstellungen in der oberen rechten Ecke.

- Wählen Sie Mein Konto aus dem Menü auf der linken Seite.

- Klicken Sie auf die Schaltfläche Konto löschen.

- Geben Sie Ihr Passwort ein, um die Löschung zu bestätigen, und wählen Sie Konto löschen.

Hinweis: Vergewissern Sie sich, dass Sie alle Ihre Webseiten entfernt haben, bevor Sie mit der Löschung Ihres TWIPLA-Kontos fortfahren.

Kann ich mehrere Webseiten mit demselben Konto betreiben?

Ja, Sie können eine unbegrenzte Anzahl von Webseiten unter demselben Konto verwalten. Um mehr darüber zu erfahren, wie Sie diese verwalten können, finden Sie zusätzliche Informationen hier.

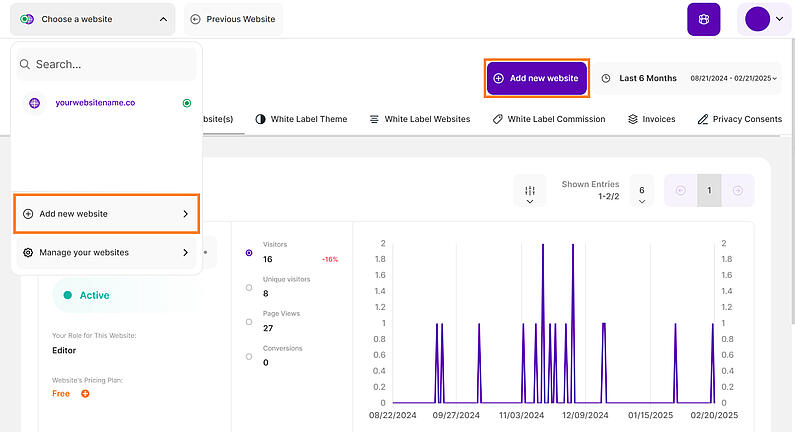

Wie kann ich Websites hinzufügen oder entfernen?

Mit TWIPLA können Sie eine unbegrenzte Anzahl von Websites zu Ihrem Konto hinzufügen. Jede hinzugefügte Website hat ihren eigenen Tracking-Code, ihre eigenen Einstellungen und ihren eigenen Abonnementbereich, und Sie können sie alle von einem Ort aus verwalten.

- Melden Sie sich bei Ihrem TWIPLA-Konto an .

- Klicken Sie auf das Dropdown-Menü in der oberen linken Ecke mit der Bezeichnung Website auswählen.

- Klicken Sie auf die Schaltfläche Neue Website hinzufügen(diese Schaltfläche finden Sie auch oben rechts auf dem Bildschirm, wenn Sie auf Websites verwalten gehen ).

- Fügen Sie Ihre neue Domain hinzu und wählen Sie dann Ihren bevorzugten Datenschutzmodus.

- Installieren Sie den Tracking-Code auf Ihrer Website. Alternativ können Sie den Code auch später installieren, indem Sie auf die Schaltfläche Tracking-Snippet später installieren klicken.

Hinweis: Sie können so viele Websites hinzufügen, wie Sie möchten, und den Abonnementplan auswählen, der Ihrem Website-Traffic entspricht. Jede Website wird unabhängig abgerechnet, aber Sie können sie alle von einem Konto aus verwalten.

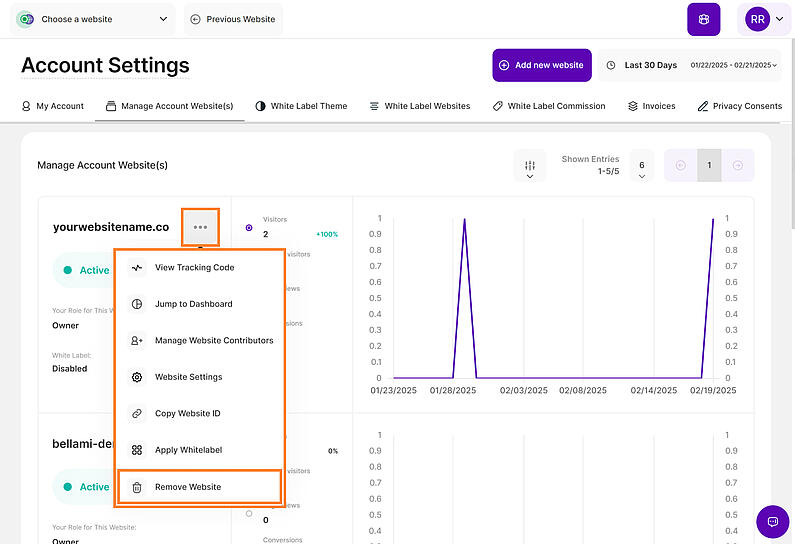

- Einloggenbei Ihrem TWIPLA-Konto an.

- Gehen Sie zu Kontoeinstellungen > Konto-Website(s) verwalten(oder wählen Sie Verwalten Sie Ihre Websites aus dem Dropdown-Menü in der oberen linken Ecke).

- Identifizieren Sie die Website, die Sie entfernen möchten, klicken Sie auf das 3-Punkte-Menü und wählen Sie dann Website entfernen.

- Geben Sie zur Bestätigung Ihr Passwort ein und klicken Sie auf Website löschen.

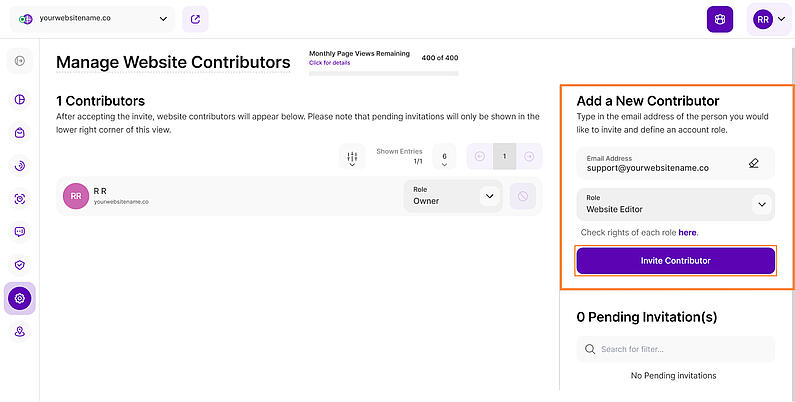

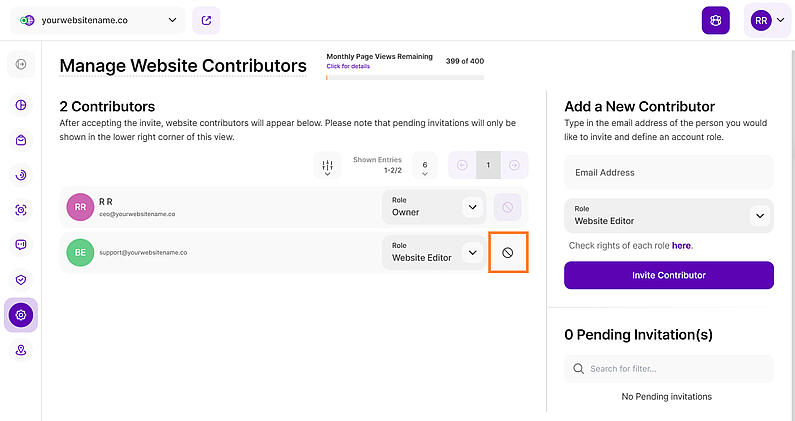

Wie kann ich Mitwirkende für eine Website hinzufügen oder entfernen?

Als Mitwirkender kann ein Benutzer (ohne Bearbeitungsrechte) alle Ihre Website-Analysen einsehen, einschließlich Informationen wie Besucher, neue Besucher, IP-Adressen (wenn die IP-Anonymisierung nicht aktiviert ist), Seitenbesuche, Absprungraten, Konversionen und sogar Live-Besucher ab dem Zeitpunkt, an dem sie die Website betreten.

HinweisAbonnementeinstellungen( Rechnungsstellung, Kartendetails, Rechnungen usw.) werden für keinen Beitragszahler angezeigt.

- Melden Sie sichbei Ihrem TWIPLA-Konto an.

- Gehen Sie zuVerwalten Sie Ihre Websites.

- Wählen Sie die Website aus, zu der Sie einen Mitwirkenden hinzufügen möchten.

- Klicken Sie auf das Menüsymbol mit den drei Punkten und wählen Sie Website-Mitwirkende verwalten.

- Gehen Sie zu Neuer Mitwirkender, geben Sie die E-Mail-Adresse der Person ein, die Sie einladen möchten, und geben Sie deren Kontorolle an.

- Nach dem Versenden der Einladung wird rechts auf der Seite die Meldung"Einladung an Mitwirkende gesendet" angezeigt, und die eingeladene E-Mail-Adresse erscheint im Abschnitt"Ausstehende Einladung(en)".

Hinweis: Wenn der Mitwirkende bereits über ein TWIPLA-Konto verfügt, braucht er nur die Rolle des Mitwirkenden zu akzeptieren, und die Website-Daten werden in seinem Konto angezeigt. Wenn der Mitwirkende nicht registriert ist, sollte er sich zunächst unter diesem Link anmelden, auf Registrieren klicken und ein TWIPLA-Konto erstellen, um die Mitwirkungsrolle annehmen zu können. Mehr über die verschiedenen Rollen können Sie hier lesen.

- Melden Sie sichbei Ihrem TWIPLA-Konto an.

- Gehen Sie zuVerwalten Sie Ihre Websites.

- Identifizieren Sie die Website(s) mit dem/den Mitwirkenden, die Sie entfernen möchten.

- Klicken Sie auf das Menüsymbol mit den drei Punkten und wählen Sie Website-Beitragende verwalten.

- Klicken Sie auf das Symbol Mitwirkende entfernen (🛇) auf der rechten Seite des Namens des Mitwirkenden.

- Geben Sie zur Bestätigung Ihr Passwort ein und klicken Sie auf Löschen.

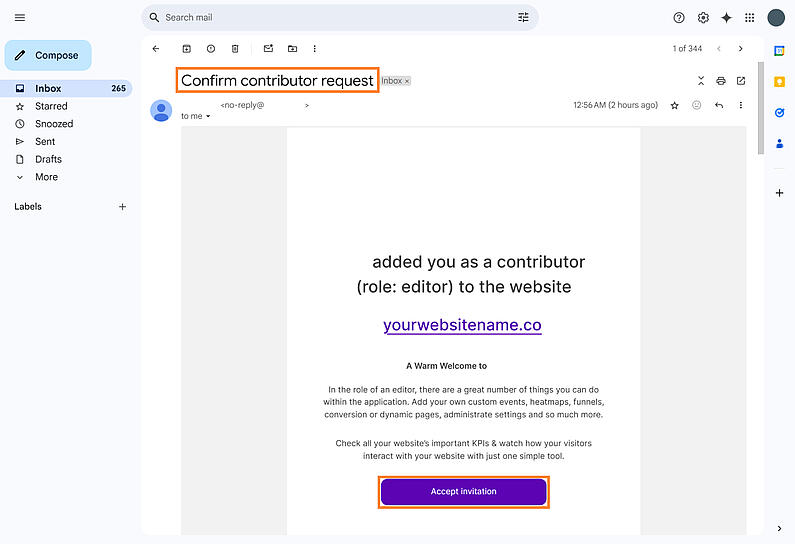

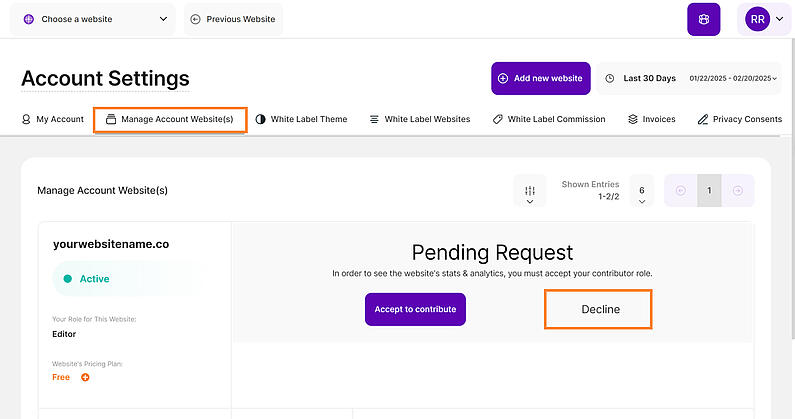

Wie kann ich eine Einladung zur Mitarbeit auf einer Website annehmen oder ablehnen?

Mit einer Einladung zum Mitwirken können Sie bei der Verwaltung einer Website mitwirken. Sie erhalten Zugang, um Änderungen vorzunehmen, Inhalte hinzuzufügen oder andere Aufgaben zu erledigen, je nachdem, was der Eigentümer erlaubt. Dies ist eine einfache Möglichkeit für Teams, zusammenzuarbeiten und eine Website reibungslos am Laufen zu halten.

- Prüfen Sie Ihren E-Mail-Posteingang und suchen Sie nach der Einladung mit dem Betreff "Antrag auf Mitwirkung bestätigen".

- Klicken Sie auf Einladung annehmen.

- Registrieren Sie sich oder Anmeldung bei TWIPLA (je nachdem, ob Sie ein Konto haben oder nicht), indem Sie auf diesen Link.

- Akzeptieren Sie die Rolle des Mitwirkenden, wenn die Meldung angezeigt wird.

- Oder wenn die Meldung bereits geschlossen wurde, gehen Sie einfach zu Verwalten Sie Ihre Websitesund identifizieren Sie die Website(s), die Ihre Rolle im Status "Ausstehend" haben, und akzeptieren Sie sie.

- Melden Sie sich bei Ihrem TWIPLA-Konto an.

- Wenn die Einladungsbenachrichtigung erscheint, klicken Sie auf die Schaltfläche"Ablehnen", um sie abzulehnen.

- Wenn Sie die Benachrichtigung bereits abgelehnt haben, navigieren Sie zuVerwalten Sie Ihre Websites und suchen Sie die Website(s) mit dem Beitragsstatus "Ausstehend" und wählen Sie"Ablehnen".

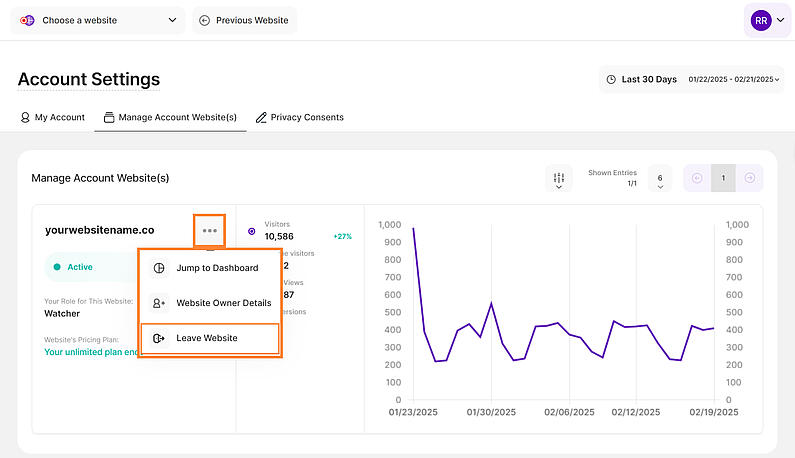

Wie kann ich mich als Beitragszahler von einer Website abmelden?

- Melden Sie sichbei Ihrem TWIPLA-Konto an.

- Gehen Sie zuVerwalten Sie Ihre Websites.

- Wählen Sie die Website aus, zu der Sie keinen Beitrag mehr leisten möchten.

- Klicken Sie auf das Drei-Punkte-Menü-Symbol und wählen Sie dann Website verlassen.

- Geben Sie zur Bestätigung Ihr Passwort ein und klicken Sie auf Verlassen.

Hinweise:

- Mitwirkende haben keinen Zugriff auf die Abonnementeinstellungen, einschließlich Rechnungsstellung, Kartendetails und Rechnungen.

- Die Rolle des Mitwirkenden wird pro Website und nicht pro Konto zugewiesen. Wenn Sie möchten, dass eine Person für mehrere Websites einen Beitrag leistet (oder umgekehrt), müssen Sie die oben genannten Schritte für jede Website einzeln durchführen.

Welcher Abonnementplan ist der beste für meine Webseite?

Wählen Sie den Plan oder die Plattform, die am besten zu Ihren Bedürfnissen passt und wechseln Sie den Plan je nach Leistung, wann immer Sie wollen - ohne Bedingungen.

Wir bieten mehrere Tarife an, die auf verschiedene Ebenen des Webseiten-Traffics zugeschnitten sind, so dass Sie den Tarif auswählen können, der Ihren aktuellen Anforderungen entspricht. Wenn der Traffic auf Ihrer Webseite zunimmt, können Sie jederzeit den Tarif wechseln.

Erkunden Sie unsere Pakete hier.

Wenn Sie einen maßgeschneiderten Plan speziell für Ihre stark frequentierte Webseite wünschen, wenden Sie sich an uns, und wir werden es möglich machen!

Läuft der kostenlose Plan aus?

Nein, Sie können den kostenlosen Tarif auf unbestimmte Zeit nutzen. Es hat jedoch Einschränkungen: Es umfasst nur 400 Seitenbesuche pro Monat und bietet einen Datenverlauf von 40 Tagen. Wenn Sie diese Grenze überschreiten, werden alle nicht aufgezeichneten Besuche nicht gespeichert. Sie können jederzeit ein Upgrade durchführen, um auf den gesamten aufgezeichneten Datenverlauf zuzugreifen, aber Besuche, die während des kostenlosen Tarifs nicht aufgezeichnet wurden, können nach dem Upgrade nicht mehr wiederhergestellt werden.

Erkunden Sie die gesamte Bandbreite an Funktionen und die entsprechenden Limits in unseren verschiedenen Tarifen hier.

Was geschieht, wenn die Höchstzahl der in meinem Plan enthaltenen Besuche erreicht ist?

Sobald Sie das Limit erreicht haben, wird TWIPLA die Aufzeichnung neuer Besuche bis zum Beginn eines neuen Monats oder bis zum Upgrade auf einen höheren Premium-Tarif einstellen.

- Denken Sie daran, dass Ihre Daten in der Zeit zwischen dem Erreichen des Limits und dem Beginn eines neuen Monats oder dem Upgrade auf einen höheren Tarif nicht nachverfolgt werden. Selbst wenn Sie später ein Upgrade durchführen, gehen die Daten aus diesem Zeitraum verloren.

- In-App-Benachrichtigungen weisen Sie darauf hin, wenn Sie sich dem Limit nähern: bei 50%, 75%, 90% und eine abschließende Popup-Meldung, wenn das Limit zu 100% erreicht ist. Es wird empfohlen, das Dashboard der App regelmäßig zu überprüfen, um sicherzustellen, dass Sie diese Benachrichtigungen rechtzeitig wahrnehmen.

Egal, ob Sie ein Monats- oder Jahresabonnement haben, Sie können jederzeit das Abonnement wechseln!

Folgen Sie diesen Schritten, um Ihr Abonnement zu ändern:

- Loggen Sie sich in Ihr TWIPLA-Konto ein.

- Wählen Sie Ihre zu aktualisierende Webseite aus.

- Gehen Sie zu Webseiten-Einstellungen --> Abonnement.

- Wählen Sie Plan ändern.

- Wählen Sie einen neuen Jahres- oder Monatstarif und fahren Sie mit der Zahlung fort.

Anmerkungen:

- Wenn Sie bereits ein aktives Premium-Abonnement haben und es ändern möchten, wird ein Rabatt für den ungenutzten Zeitraum des vorherigen Abonnements gewährt. Wenn Sie jedoch die automatische Verlängerung für Ihr aktuelles Abonnement deaktiviert haben und auf ein anderes aktualisieren möchten, wird der verbleibende ungenutzte Zeitraum nicht berücksichtigt.

- Um eine Unterbrechung des Dienstes zu vermeiden, sind die App-Abonnements so eingestellt, dass sie sich automatisch verlängern. Sie können die automatische Verlängerung jederzeit deaktivieren, wenn Sie sie nicht mehr benötigen. Am Ende des Zyklus endet Ihr Abonnement, und Sie kehren zur kostenlosen Version der App zurück.

Befolgen Sie diese Schritte, um Ihre Rechnungsdaten in den Abonnementeinstellungen zu aktualisieren:

- Melden Sie sich bei Ihrem TWIPLA-Konto an.

- Wählen Sie Ihre Webseite aus.

- Klicken Sie auf Webseiten-Einstellungen --> Abonnement.

- Aktualisieren Sie Ihr Formular für Rechnungsinformationen.

- Klicken Sie auf Änderungen speichern.

Hinweis: Die dort gespeicherten Informationen werden nicht automatisch in Ihre Rechnung(en) übernommen. Wenn Sie möchten, dass diese Angaben auf Ihrer/ Ihren Rechnung(en) erscheinen, müssen Sie jede Rechnung öffnen und diese Angaben manuell hinzufügen.

Wie kann ich Kreditkartendaten hinzufügen oder ändern?

Die Zahlungsmethode erscheint erst, nachdem die erste Zahlung erfolgt ist. So können Sie ein Upgrade erwerben oder Ihr Abonnement für eine Webseite ändern, indem Sie dieselbe Zahlungsmethode verwenden.

Wenn Sie Ihre registrierten Zahlungsdaten ändern möchten, gehen Sie bitte wie folgt vor:

- Melden Sie sich in Ihr TWIPLA-Konto ein.

- Wählen Sie Ihre Webseite aus.

- Klicken Sie auf Webseiten-Einstellungen --> Abonnement.

- Tippen Sie unter Zahlungsmethode auf das Bleistiftsymbol und aktualisieren Sie Ihre Zahlungsinformationen.

- Klicken Sie auf Änderungen speichern.

Hinweis: Die geänderten Zahlungsinformationen können nur für Rechnungen verwendet werden, die nach den Änderungen erstellt wurden.

Alle Rechnungen werden monatlich oder jährlich ausgestellt, je nach Ihrem Abonnementplan, und Sie können sie jederzeit einsehen und herunterladen.

Folgen Sie diesen Schritten, um Ihre Rechnung einzusehen und herunterzuladen:

- Melden Sie sich bei Ihrem TWIPLA-Konto an.

- Wählen Sie Ihre Webseite aus.

- Klicken Sie auf Webseiten-Einstellungen --> Abonnement.

- Navigieren Sie zu Rechnungen, um die gewünschte Rechnung anzuzeigen und herunterzuladen.

Hinweis: Wenn Sie mehrere Webseiten und Abonnementpläne haben, können Sie alle Ihre Rechnungen an einem Ort einsehen, indem Sie zu Kontoeinstellungen (obere rechte Ecke) und wählen Sie die Option Rechnungen aus (weitere Informationen finden Sie in der vorherigen Frage).

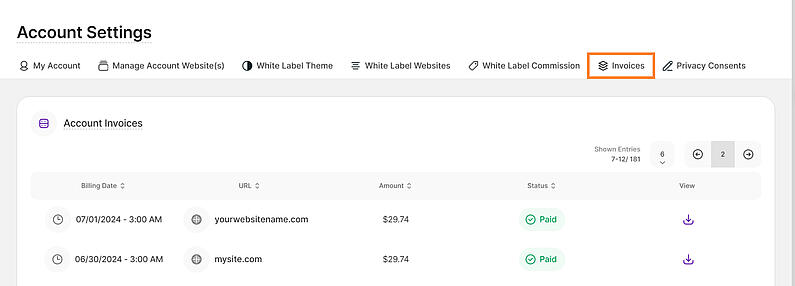

Wie verwalte ich meine Rechnungen für alle meine Webseiten?

Navigieren Sie zu Rechnungen und sehen Sie sich die Liste aller Rechnungen für alle Ihre Webseiten an einem Ort an.

Wichtige Hinweise:

- Diese Rechnungen beziehen sich nur auf "Nicht-Wix-Webseiten". Die Abrechnung für Wix-Webseiten erfolgt separat über WiX.

- Die Rechnungen erscheinen innerhalb von 24 Stunden nach dem Kauf in Ihrem Konto.

- Diese Ansicht enthält alle Rechnungen von allen Webseiten, die Ihrem TWIPLA-Konto hinzugefügt wurden. Wenn Sie nur die Rechnungen der einzelnen Webseiten sehen möchten, gehen Sie bitte zu Webseiten-Einstellungen --> Abonnement --> Rechnungen.

Die Tabelle besteht aus den folgenden Spalten:

- Rechnungsdatum: Datum, an dem die Rechnung erstellt wurde.

- URL: Bezieht sich auf die Internetadresse der Webseite, auf die sich diese Rechnung bezieht.

- Betrag: Der Rechnungsbetrag in USD (weitere Währungen werden bald verfügbar sein).

- Status: Status der Zahlung (Bezahlt, unbezahlt, etc.).

- Ansicht: Wenn Sie auf das entsprechende Download-Symbol in dieser Tabelle klicken, werden Sie zu einem neuen Bildschirm weitergeleitet, auf dem Sie die Rechnung ansehen können.

Wie erhalte ich mit meinem Mobiltelefon einfachen Zugang zum TWIPLA?

Wenn Sie die TWIPLA Web-App auf Ihrem mobilen Gerät öffnen wollen, müssen Sie in der Regel zuerst einen Browser öffnen, die Adresse der Webseite eingeben, suchen und sich dann anmelden. Das alles dauert relativ lange. Wenn Sie in Ihrem Browser ein Lesezeichen anlegen, sparen Sie viel Zeit: Es funktioniert ähnlich wie eine mobile App, verbraucht aber nicht den Speicher Ihres Handys. Hier sind ein paar Schritte, um schnell und einfach eine TWIPLA Dashboard-Verknüpfung für Android- und iOS-Geräte zu erstellen:

Android

- Öffnen Sie Ihren mobilen Browser.

- Geben Sie in der Adressleiste diesen Link ein: https://app.twipla.com/

- Wählen Sie das Symbol mit den "drei Punkten" in der oberen rechten Ecke Ihres Browsers.

- Wählen Sie "Zum Startbildschirm hinzufügen".

- Geben Sie der App einen Namen und wählen Sie "Hinzufügen".

- Starten Sie die Web-App ganz einfach über den Startbildschirm Ihres Telefons.

Hinweis: Die Schaltflächen und Symbole können je nach verwendetem Browser variieren (manche Browser bieten diese Möglichkeit gar nicht mehr an). Zum Beispiel:

- Chrome, Opera, DuckDuckGo haben ähnliche Optionen.

- Firefox bietet ein Home-Symbol mit einem "+" darin.

- Edge bietet das "Drei-Punkte-Symbol" in der unteren rechten Ecke.

iOS

- Öffnen Sie Ihren mobilen Safari-Browser.

- Geben Sie in der Adressleiste diesen Link ein: https://app.twipla.com/

- Klicken Sie auf die Schaltfläche "Freigeben" unten in Ihrem Browser.

- Wählen Sie "Zum Startbildschirm hinzufügen".

- Geben Sie der App einen Namen und wählen Sie "Hinzufügen".

- Starten Sie die Web-App ganz einfach vom Startbildschirm Ihres Telefons aus.

Wo liegen die Grenzen der Funktion Sitzungsaufzeichnungen?

Mit den Sitzungsaufzeichnungen können Sie Videos aufnehmen und abspielen, die zeigen, was Besucher auf Ihrer Webseite gemacht haben!

Wir wissen, wie wichtig es ist, zu sehen, was Ihre Kunden auf der Webseite tun. Mit Sitzungsaufzeichnungen können Sie das gesamte Besuchererlebnis wiedergeben, Probleme identifizieren, Konversionen steigern und Ihre Webseite optimieren. Es gibt jedoch einige Einschränkungen, die uns daran hindern, bestimmte Dinge auf Ihrer Webseite aufzuzeichnen, und zwar aufgrund einiger technischer Sicherheitsklauseln.

Es gibt alle Arten von Webseiten, und leider gibt es einige Einschränkungen für die Funktion Sitzungsaufzeichnungen:

- Wenn Sie iFrames, Bilder oder SVGs auf Ihrer Webseite haben, die Teil eines tiefliegenden iFrames sind, kann es sein, dass Sie die Meldung "Inhalt nicht verfügbar" / "Content not available" sehen, da wir nicht auf iFrames zugreifen können. Die Inhalte Dritter befinden sich auf einer anderen Domain und unser Javascript kann sie nicht abfangen. Dasselbe gilt für die Aufzeichnungen, die für Besuche von Nutzern erstellt werden, die AdBlocker in ihrem Browser verwenden.

- Wenn auf Ihrem Wix-Blog oder Ihrer Webseite zusätzliche Pop-ups, Apps oder Widgets installiert sind, kann TWIPLA aus Sicherheitsgründen nicht auf diese Informationen zugreifen, da es sich dabei um Apps von Drittanbietern handelt und unser Code zu Ihrer Webseiten-Domain hinzugefügt wird.

- Parallaxes Scrollen wird am besten über Firefox-Browser wiedergegeben.

- Bei einigen dynamischen Seiten kann es zu Problemen bei der Anzeige von Hover-Elementen kommen (z. B. bei eCommerce-Anwendungen in Wix).

- Es kann sein, dass einige Datensätze nicht in Ihrer Liste erscheinen, weil die Besucher die Option "Do Not Track" in ihren Browsern aktiviert haben. Eine andere Möglichkeit wäre die Aktivierung der Option "Easy Privacy" in ihrem Werbeblocker/ihrer Erweiterung.

Hinweis: Wenn keine der hier beschriebenen Ausnahmen auf Ihre Besucher zutrifft, müssen Ihre Besucher die Webseite erst verlassen haben, bevor Sie die Aufzeichnung sehen können. Auch wenn eine Aufzeichnung nicht verfügbare Inhalte zeigt, können Sie sicher sein, dass Ihre Besucher die echten Inhalte sehen.

Sie können die Daten Ihrer Besucher oder den Verlauf der Seitenaufrufe jederzeit ganz einfach als .csv oder .xlsx exportieren! Führen Sie dazu bitte die folgenden Schritte aus:

- Loggen Sie sich ein in Ihr TWIPLA-Konto ein und wählen Sie Ihre Webseite aus.

- Wählen Sie im Menü auf der linken Seite Webseiten-Einstellungen -->Exportieren.

- Wählen Sie, welche Daten Sie exportieren möchten (Besucher oder Seitenaufrufe).

- Wählen SiedenZeitbereich und den Dateityp aus und klicken Sie dann auf Exportieren.

Alles über die Exportfunktion finden Sie hier.

Wichtiger Hinweis: Gute Neuigkeiten! Wir haben die 31-Tage-Beschränkung aufgehoben, so dass Sie Ihre Daten für jeden gewünschten Zeitraum analysieren können.

Wie kann ich meine URL-Kampagnen verfolgen?

URL-Kampagnen oder UTM-Parameter werden NICHT IN der TWIPLA-App eingerichtet. Sie werden lediglich automatisch von der App erkannt, sobald ein Besucher eine UTM-Link verwendet, den Sie an anderer Stelle eingerichtet und eingebettet haben. Hier können Sie mehr über UTM-Kampagnen erfahren.

Wie wäre es, wenn Sie Ihre Kampagnenbesucher nach Parametern wie "Quelle" oder "Medium" unterteilen und überprüfen könnten, welche Parameter Ihnen die meisten Besucher bringen?

Um den genauen Referrer (z.B. Newsletter), das Marketingmedium (organisch, PPC, Banner), den Kampagnennamen oder andere Informationen, die nachverfolgt werden können, herauszufinden, fügen Sie einfach Kampagnenparameter zu Ihren URL-Kampagnen hinzu.

Bitte befolgen Sie dazu die folgenden Schritte:

- Navigieren Sie zu unserem UTM-URL-Generator.

- Geben Sie Ihre Webseiten-URL ein und füllen Sie das Formular mit den gewünschten Parametern (z. B. signup_button).

- Kopieren Sie die resultierende URL.

- Nutzen Sie den kopierten Link in Ihren Kampagnen und beobachten Sie die weitere Entwicklung!

Wie präzise lässt sich der Standort meiner Besucher bestimmen?

Da wir eine Analyse-App anbieten, müssen wir die Datenschutzgesetze und -richtlinien respektieren und können nur einen ungefähren Standort der Besucher angeben.

Um diese Funktion im Detail zu verstehen, sind hier einige Dinge zu beachten:

- Normalerweise gibt ein Internetdienstanbieter aus Sicherheitsgründen den ungefähren Standort einer bestimmten IP-Adresse an (z. B. die Stadt und manchmal auch die Nachbarschaft). Wenn wir Ihnen den Standort des Besuchers anzeigen, sind wir gesetzlich verpflichtet, die tatsächliche Adresse nicht anzuzeigen (dies ist die zweite Ebene der Anonymität, die gesetzlich vorgeschrieben ist), also zeigen wir einen ungefähren Standort an.

- Wenn die Besuche über Mobiltelefone erfolgen, wird der Standort durch den Haupt-WiFi-Turm des Internetanbieters angegeben (der sich normalerweise nicht in derselben Straße wie die Besucher befindet).

- Wir überprüfen die Standorte anhand der IP-Adressen, und jede IP-Adresse wird von dem Dienst, der sie zugewiesen hat, mit einem ungefähren Standort registriert. Wir verwenden diese Daten so, wie sie von den einzelnen Internetanbietern registriert und aktualisiert werden, und zeigen sie so an, wie sie sind.

Hinweis: Der Standort-Pin bewegt sich jedes Mal, wenn Sie die Karte aktualisieren, in einem bestimmten Bereich von Ort zu Ort. Der Radius wird von der App berücksichtigt und sie bewegt den Pin in diesem spezifischen Bereich, damit Sie nicht den Eindruck haben, dass der Besucher von genau diesem Ort kommt, sondern aus diesem Bereich.

Kann ich die Besucher verfolgen, die auf eine bestimmte Schaltfläche auf meiner Webseite klicken?

Abhängig von Ihrer Schaltfläche kann unsere Antwort unterschiedlich ausfallen.

Wenn Ihre Schaltfläche zu einer anderen Seite innerhalb Ihrer Webseite oder zu einem Dokument mit Ihrer Webseiten-URL führt, können Sie die Schaltfläche mithilfe der UTM-Kampagnenfunktion nachverfolgen. Bitte befolgen Sie dazu die folgenden Schritte:

- Navigieren Sie zu unserem UTM-URL-Generator.

- Geben Sie die Daten ein, beginnend mit Ihrer Webseiten-URL, und fügen Sie dann Ihre bevorzugten Parameter hinzu (z.B.: signup_button).

- Kopieren Sie anschließend den generierten UTM-Kampagnen-Link.

- Fügen Sie ihn in Ihre Schaltfläche ein, z. B. Button

- Das war's! Überprüfen Sie Ihre URL-Kampagnen-Statistiken.

Eine weitere Möglichkeit, um zu verfolgen, wer sich angemeldet oder einen bestimmten Button ausgewählt hat, besteht darin, eine versteckte "Danke"-Seite auf Ihrer Webseite zu erstellen (da sie versteckt ist, können Sie genauere Statistiken erstellen) und sie mit Ihrem Button zu verknüpfen. Auf diese Weise werden Ihre Besucher auf diese spezielle Seite umgeleitet, die als Konversionsseite eingerichtet werden kann.

Wie kann ich die Option "Ignoriere (eigene) Besuche für das IP-Tracking" in Safari aktiviert lassen?

Webseiten speichern oft Cookies und andere Daten auf Ihrem Mac. Diese Daten können Informationen enthalten, die Sie zur Verfügung gestellt haben, z. B. Ihren Namen, Ihre E-Mail-Adresse und Ihre Präferenzen. Diese Daten helfen Webseiten, Sie zu identifizieren, wenn Sie auf die Webseite zurückkehren, und können Ihnen Dienste anbieten und Informationen anzeigen, die für Sie von Interesse sein könnten.

Unsere App setzt einen Cookie für Ihre Webseite, wenn Sie sich dafür entscheiden, Ihre eigenen Besuche zu ignorieren. Vergewissern Sie sich, dass Cookies in Safari nicht blockiert werden, so dass die Option "Ignorieren von (eigenen) Besuchen für das IP-Tracking" aktiv bleibt. Um Cookies zu aktivieren, navigieren Sie zu Safari --> Einstellungen --> Datenschutz und deaktivieren Sie die Option "Alle Cookies blockieren". Laden Sie die App anschließend erneut.

Warum erhalte ich Besuche aus Ländern, zu denen meine Webseite keinen Bezug hat?

Wir verstehen, dass Sie Besucher erhalten, die schwer zu erklären sind, aber leider sind wir nicht in der Lage, Informationen über die Quelle des Traffics zu geben.

Da Ihre Webseite weltweit zugänglich ist, könnten diese Besuche tatsächlich echt sein. Außerdem könnten einige Ihrer Besucher VPN-Verbindungen nutzen, was es schwierig macht, ihren tatsächlichen Standort zu ermitteln.

Eine mögliche Lösung besteht darin, Besuche auf der Grundlage von IPs zu ignorieren. Sie können unter Webseiten-Einstellungen --> Allgemein --> (Eigene) Besuche ignorieren nach IP die unerwünschten IPs einfach zu Ihrer Liste der unerwünschten IPs hinzufügen. Damit werden diese Besuche nicht mehr in Ihren Statistiken auftauchen. Weitere Informationen finden Sie hier.

Kann ich Besucher aus einem bestimmten Land vom Besuch meiner Webseite ausschließen?

Leider können wir den Zugriff von Nutzern auf Ihre Webseite nicht blockieren. Wir bieten jedoch die Möglichkeit, sie zu ignorieren. Wenn Sie Besuche von einer bestimmten IP oder einer Reihe von IPs ignorieren möchten, befolgen Sie einfach die im folgenden Artikel beschriebenen Schritte: Ignorieren (eigener) Besuche für die Verfolgung nach IP

Hinweis: Das Ignorieren der Besuche von einer bestimmten IP bedeutet, dass die Besuche zwar noch stattfinden, aber nicht in den Statistiken angezeigt werden. Es ist wichtig zu bedenken, dass einige Besucher, selbst aus Ihrer Zielregion, möglicherweise VPN-Verbindungen nutzen. In solchen Fällen können Sie sich dafür entscheiden, die Besuche von diesen Besuchern nicht zu ignorieren.

Kann ich die Unternehmensdaten oder die E-Mail-Adresse meiner Besucher sehen?

TWIPLA ist eine Analyse-App, die den Traffic Ihrer Webseite leicht lesbar und verständlich macht. Sie können sich einfach sehen, woher Ihr Publikum kommt (Verweise), IP & Standort, verwendete Gerät, Bildschirmgrößen, Betriebssystem, Browser und das Verhalten von Besuchern auf Ihrer Webseite, besuchte Seiten, Sitzungsaufzeichnungen und Bereiche, mit denen Besucher am meisten interagieren usw.

Wir können Ihnen nur Analysen über Ihre Webseite zur Verfügung stellen, damit Sie einen besseren Überblick über Ihre Leistungen oder die Möglichkeiten einer besseren Kommunikation erhalten. Aufgrund einiger Datenschutzrichtlinien ist es Analyse-Apps nicht gestattet, E-Mails oder andere sensible Informationen zu sammeln.

Warum gibt es mehrere IP-Adressen für ein und denselben Besucher?

Besucher verwenden oft VPN-Verbindungen oder haben dynamische IPs, aber sie benutzen denselben Browser, um auf Ihrer Webseite zu surfen. Wir verfolgen Besucher auf der Grundlage ihres verwendeten Browsers. Wenn sie denselben Browser verwenden, aber unterschiedliche IPs haben, erkennen wir sie als dieselben Besucher.

Es kann auch sein, dass Sie dieselbe IP-Adresse mehrmals als neuen Besucher sehen. Wenn die IP-Adresse bei mehreren Nutzern vom selben Router stammt, werden sie alle als eindeutige Besucher angezeigt, da es sich um neue Personen handelt, die unterschiedliche Geräte und implizit unterschiedliche Browser verwenden, aber dieselbe IP-Adresse haben. Dies kann in Büros oder überall dort vorkommen, wo mehrere Personen denselben Wifi-Router verwenden.

Um den gesamten Verlauf einer IP zu sehen, klicken Sie einfach auf die IP selbst und dann auf "Verlauf ansehen".

Warum gibt es für einige der Sitzungen keinen Hinweis?

Beachten Sie, dass nicht alle Webseiten ihren Referrer freigeben. Wir empfehlen Ihnen dringend zu prüfen, ob die Referrer-Richtlinie für Webseiten, von denen Sie eine Empfehlung erwarten, aktiviert ist. Es gibt einige Werkzeuge, mit denen Sie herausfinden können, ob die Referrer-Richtlinie auf den betreffenden Webseiten aktiviert ist.

Wie kann ich den Traffic auf meiner Webseite erhöhen?

Wir freuen uns, einige unserer Artikel mit Ihnen zu teilen, die Ihnen helfen können, Ihre Webseite zu verbessern und auch den Traffic zu erhöhen. Sehen Sie sich hierzu alle unsere Blogbeiträge an.

Warum ist die Schriftart bei der Wiedergabe meiner Sitzungsaufzeichnung anders?

Wenn die Sitzungsaufzeichnung eine andere Schriftart zeigt als die auf der Website, könnte dies ein Fall von CORS sein. Ursprungsübergreifende Ressourcenfreigabe (CORS) ist ein Browser-Mechanismus, der den kontrollierten Zugriff auf Ressourcen außerhalb einer Domäne ermöglicht. Die Website-Domäne erlaubt uns nicht, ihre Assets zu laden.

Um CORS zu aktivieren, müssen Sie den Webserver so konfigurieren, dass er einen HTTP-Header sendet, der den Fernzugriff auf seine Ressourcen erlaubt.

In dieser Ansicht können Sie identische Seiten mit unterschiedlichen URLs (z. B. dieselbe Produktseite für verschiedene Artikel) auf Ihrer Webseite für gebündelte Statistiken gruppieren.

Stellen Sie sich vor, Sie haben eine E-Commerce-Webseite. Die Wahrscheinlichkeit ist groß, dass Sie für alle Produktkäufe am Ende der Kaufabwicklung dieselbe "Danke"-Seite verwenden (auch wenn diese Seite je nach Kauf unterschiedliche dynamische Parameter in ihrer URL hat). Wenn Sie diese URLs nicht gruppieren, sehen Sie Daten auf jeder "Danke"-Seite, auch wenn es dieselben sind. Wenn Sie diese URLs gruppieren, können Sie kombinierte Statistiken für diese Seite anzeigen, aber Ihre Daten werden dadurch nicht verändert.

Wenn Sie eine neue dynamische Seite für die ausgewählte Webseite hinzufügen möchten, navigieren Sie bitte zu Besondere Seiten --> Dynamische Seiten --> Dynamische Seite hinzufügen. Es öffnet sich ein neues Modal, in dem Sie die Felder ausfüllen müssen. Probieren Sie diese Funktion aus und analysieren Sie Ihre Ergebnisse. Es kann nichts schief gehen, und Ihre Besucher werden keine Änderungen bemerken.

Hinweis: Sie können die Statistiken Ihrer selbst definierten dynamischen Seiten an verschiedenen Stellen einsehen, beispielsweise im Seiten-Dashboard.

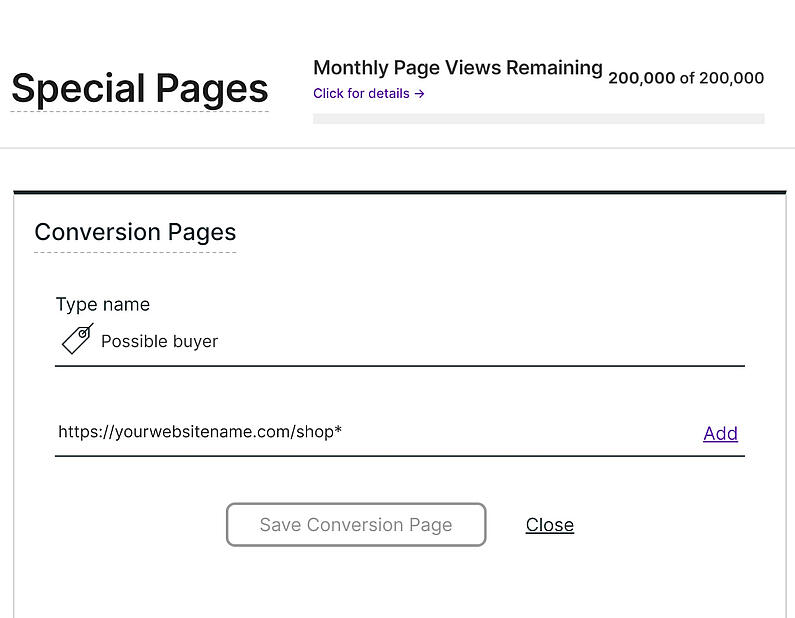

Wenn Sie zu Webseiten-Einstellungen --> Spezielle Seiten navigieren, können Sie für jede Ihrer wichtigen Seiten oder Seitengruppen einen Konversionstyp erstellen.

Wenn Sie zum Beispiel diese Seiten haben: Shop und Warenkorb, können Sie beide als Konversionstyp mit dem Namen "mögliche Käufer" hinzufügen. So können Sie die Besucher, die diese Seiten (eine oder alle) erreichen, als Konversions-Besucher vom Typ "mögliche Käufer" sehen.

Wenn Sie eine "Danke für Ihren Kauf"-Seite haben, können Sie diese auch als Konversion mit dem Namen "treuer Kunde" festlegen. Wenn ein Besucher mehrere Konversionstypen erreicht, können Sie diese in der Besucherliste wie folgt sehen: Konversionstypen: mögliche Käufer, treuer Kunde

Sie können sich auch einen besseren Überblick über die Anzahl dieser Seitenaufrufe verschaffen, wenn Sie zu Seiten --> Konversionsseiten navigieren.

Sehen Sie sich hierzu auch diesen Artikel an. Er könnte Ihnen weiterhelfen.

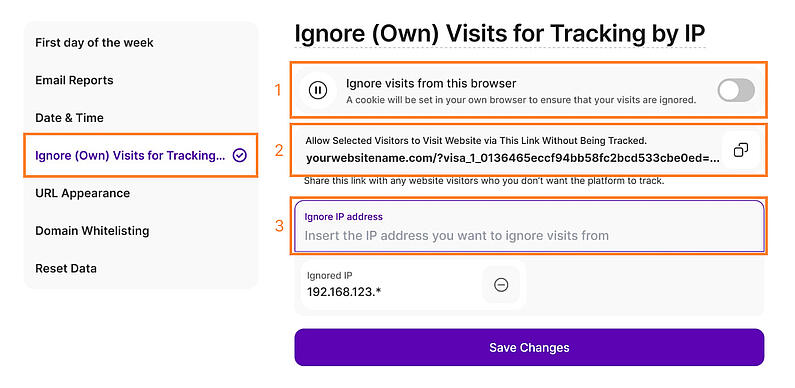

Wenn Ihre Analysen Besuche sowohl von Ihnen (oder Ihrem Team) als auch von externen Besuchern Ihrer Webseite anzeigen, kann es schwierig werden, Ihre Traffic-Leistung zu bestimmen. Wenn Sie bestimmte Besuche von Ihren Daten innerhalb des Kontos ausschließen möchten, haben Sie drei Optionen zur Auswahl:

- Besuche von diesem Browser ignorieren: Wenn Sie diese Option für Ihre eigenen Besuche aktivieren, werden diese Daten von der App nicht gezählt. Besuche von anderen Nutzern, die denselben Browser verwenden (aber mit einer anderen IP-Adresse), werden weiterhin verfolgt. Diese Einstellung bleibt so lange aktiv, bis Sie sie deaktivieren oder die Browser-Cookies löschen. Bitte stellen Sie sicher, dass Ihr Browser auch Cookies zulässt.

- Webseiten-Besucher-Tracking über diesen Link ignorieren: Wenn Sie die IPs in Ihren Einstellungen anonymisiert haben und Sie die IPs Ihres Teams nicht kennen oder einfach nicht möchten, dass ein bestimmter Besuch in Ihren Daten erscheint, teilen Sie diesen Personen bitte den Link mit, der Ihnen an dieser Stelle angezeigt wird. Wenn sie diesen Link verwenden, um Ihre Webseite zu besuchen, wird dieser Besuch nicht in die Statistik einfließen.

- IP-Adresse ignorieren: Ignorieren Sie Besuche von einer bestimmten IP-Adresse oder von Klassen von IPs, indem Sie das Symbol * am Ende der numerischen Bezeichnung verwenden - wenn z. B. eine Klasse von IPs mit 192.168.123 beginnt, fügen Sie einfach 192.168.123.* hinzu und die gesamte Klasse wird ignoriert. Nachdem Sie die IP hinzugefügt haben, klicken Sie bitte auf die Schaltfläche Änderungen speichern.

Es gibt zwei Arten von IPs: statische IPs und dynamische IPs. Eine statische IP bedeutet, dass sich Ihre IP-Adressen nicht ändern und Sie jeden Tag die gleiche IP haben, wenn Sie sich mit demselben Netzwerk verbinden. Statische IPs sind eher eine Option für Unternehmen als für Privatpersonen, da sie für spezielle Dienste wie Webserver, FTP oder Hosting von Servern sehr nützlich sind und es Geolokalisierungsdiensten einfacher machen, Ihren Standort genau zu bestimmen.

Andererseits verwenden die meisten Nutzer eine dynamische IP, welche sich regelmäßig ändert. Diese IP-Adressen werden automatisch vom Internetdienstanbieter vergeben und sind mit wenig (oder gar keinem) Aufwand zuverlässig, allerdings kann die Geolokalisierung weniger genau sein.

Hinweise:

- Stellen Sie sicher, dass Ihr Browser Cookies zulässst, wenn Sie die erste Option verwenden. Beachten Sie, dass diese Option nur für diesen speziellen Browser gilt. Wenn Sie Ihre Besuche von einem beliebigen Browser oder Gerät aus ignorieren möchten, befolgen Sie die Schritte der dritten Option.

- Wenn Sie Ihre IP-Adresse nicht kennen oder nicht wissen, ob es sich um eine statische oder dynamische IP-Adresse handelt, klicken Sie einfach hier. Sie können dort alles über Ihre IP-Adresse erfahren, wenn Sie auf Vollständige IP-Details anzeigen klicken.

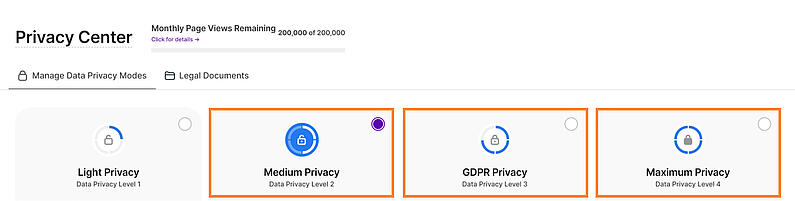

Wie kann ich die IP-Adressen meiner Besucher anonymisieren?

Um einen unserer Lieblingspartner zu zitieren: TWIPLA ist zu 100% DSGVO-konform, ISO 27001-zertifiziert und zu 0% dubios.

Wenn Sie also ein sicheres Tracking durchführen möchten, ohne die IP Ihrer Besucher aufgrund von Datenschutzbedenken in Ihrem Land zu erhalten, sind Sie hier genau richtig.

Hier ist eine Schritt-für-Schritt-Anleitung zur Anonymisierung der IPs Ihrer Besucher:

- Loggen Sie sich in Ihr TWIPLA-Konto ein.

- Navigieren Sie zum Datenschutz-Center. Sie können zwischen diesen drei Datenschutzmodi wählen:

- Stufe 2: Mittlerer Datenschutz

- Stufe 3: DSGVO-Datenschutz

- Stufe 4: Maximaler Datenschutz

- Wählen Sie Ihre bevorzugte Datenschutzeinstellung, indem Sie auf das Optionsfeld auf der rechten Seite der Karte klicken.

- Klicken Sie abschließend auf Änderungen speichern um die neuen Einstellungen zu übernehmen.

Sobald Sie die Anonymisierungsoption aktiviert haben, werden die IPs Ihrer Besucher nicht mehr gespeichert. Alles über das Datenschutz-Center und vieles mehr finden Sie hier.

Hinweis: Wenn Sie die IP-Anonymisierung aktivieren, werden Sie keine IP-Adressen innerhalb von TWIPLA sehen. Wir verfolgen Ihre Besucher über ein Cookie und nicht über die IP-Adresse und es hat keinerlei Auswirkungen auf Ihre Daten.

Wie ändere ich die E-Mail-Adresse, an die ich Berichte erhalten möchte?

Wenn Sie zu den allgemeinen Einstellungen der ausgewählten Webseite navigieren, finden Sie die Option E-Mail-BerichteOption. In diesem Abschnitt können Sie die E-Mail-Adresse, die für Ihre Statistikberichte verwendet werden soll, einfach ändern und speichern. Hier können Sie auch die Option zum Erhalt von Statistikberichten aktivieren oder deaktivieren und die Häufigkeit der Berichte festlegen.

Gehen Sie folgendermaßen vor, um die E-Mail-Adresse zu ändern:

- Klicken Sie auf die Schaltfläche E-Mail-Adresse(n) hinzufügen, an die E-Mail-Berichte gesendet werden sollen.

- Geben Sie Ihre neue E-Mail-Adresse ein. Sie können auf das Symbol (-) klicken, um die vorhandene E-Mail-Adresse zu entfernen.

- Klicken Sie auf Änderungen speichern um die neuen Einstellungen zu übernehmen.

Alles über die entsprechenden Funktionen der App und vieles mehr finden Sie hier.

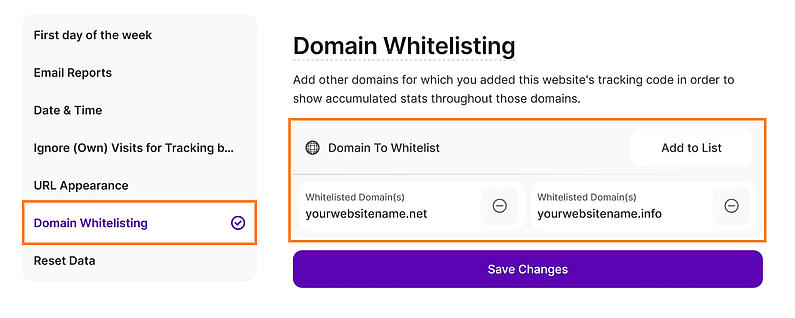

Wie kann ich eine Domain/Subdomain meiner Webseite auf die Whitelist setzen?

Wenn Sie TWIPLA auf mehreren Domains verwenden möchten, die mit derselben Webseite verbunden sind, stehen wir Ihnen zur Seite! Domain-Whitelisting ist jetzt in Ihren allgemeinen Einstellungen verfügbar und ermöglicht es Ihnen, so viele Domains wie nötig auf die Whitelist zu setzen.

Wie diese Funktion Ihrem Unternehmen hilft:

- Indem Sie eine Domain auf die Whitelist setzen, können Sie den Tracking-Code Ihrer Webseite auf anderen Domains oder Subdomains einbinden, die Sie besitzen und die Sie als Teil Ihrer Webseite oder Ihres Unternehmens betrachten, z. B. Landing Pages, Blogs oder temporäre Projekte, die Sie verfolgen möchten.

- Wenn Ihre Webseite beispielsweise mywebsite.com heißt, können Sie Ihren Tracking-Code für blog.mywebsite.com, webinar.mywebsite.com und mywebsite.shopify.com auf die Whitelist setzen und alle Besuche unter einem einzigen TWIPLA-Konto und einer einzigen Webseite verfolgen. Sie müssen nicht mehrere Tracking-Codes verwenden und ständig die Seiten wechseln, um Ihre Statistiken zu sehen!

Folgen Sie diesen Schritten, um Ihre Domains auf die Whitelist zu setzen:

- Loggen Sie sich in Ihr TWIPLA-Konto ein und wählen Sie Ihre Webseite aus.

- Navigieren Sie zu Webseiten-Einstellungen --> Allgemein

- Scrollen Sie nach unten und suchen Sie den Punkt Domain-Whitelisting Abschnitt.

- Geben Sie Ihre Domain unter Domain auf der Whitelist ein und klicken Sie auf Zur Liste hinzufügen.

- Klicken Sie auf Änderungen speichern um die neuen Einstellungen zu übernehmen.

- Binden Sie denselben Tracking-Code auch in den Quellcode der Subdomain ein (denselben wie für die Hauptdomain).

Nachdem Sie die Domains hinzugefügt haben:

- Um die Domains auf der Whitelist anzuzeigen, überprüfen Sie Ihre Allgemeinen Einstellungen und scrollen Sie zum Abschnitt Domain-Whitelisting.

- Um eine Domain aus der Whitelist zu löschen, wählen Sie die Domain aus, klicken Sie auf die Schaltfläche Löschen und klicken Sie dann auf Änderungen speichern.

- Sie können Domains hinzufügen oder entfernen, wenn Sie Ihr Unternehmen ausbauen.

Hinweis: Die Aufnahme Ihrer eigenen Domain in die Whitelist erhöht die Sicherheit Ihres Kontos, da sie verhindert, dass andere Domains Ihr Tracking-Skript verwenden!

Beim Zurücksetzen der Daten werden alle Ihre Webseiten-Statistiken gelöscht, aber Ihre Einstellungen bleiben unverändert. Wenn Sie sich dafür entscheiden, diese Daten per E-Mail zu erhalten, senden wir Ihnen zunächst einen Link mit dem Archiv Ihrer Webseiten-Statistiken und fahren dann mit dem Zurücksetzen fort. Bitte beachten Sie, dass diese Vorgänge je nach Traffic auf Ihrer Webseite bis zu 24 Stunden dauern können. Während des Zurücksetzens werden Ihre Statistiken nicht nachverfolgt.

Um Ihre Daten zurückzusetzen, folgen Sie bitte diesen Schritten:

- Loggen Sie sich in Ihre TWIPLA-Konto ein und wählen Sie Ihre Webseite aus.

- Navigieren Sie zu Webseiten-Einstellungen --> Allgemein.

- Scrollen Sie nach unten zum Punkt Webseiten-Daten zurücksetzen und klicken Sie auf die Schaltfläche Alle Webseiten-Daten zurücksetzen.

- Markieren Sie das Kästchen neben Webseiten-Daten vor dem Zurücksetzen per E-Mail an mich senden, wenn Sie vor dem Zurücksetzen eine Kopie Ihrer Daten erhalten möchten.

- Geben Sie zur Bestätigung Ihr Passwort ein und klicken Sie auf Daten zurücksetzen.

Hinweis: Alle bestehenden Statistiken werden durch diesen Vorgang dauerhaft gelöscht. Sobald Sie die Statistiken zurückgesetzt haben, kann der Vorgang nicht mehr rückgängig gemacht werden.

Wann ist es empfehlenswert Daten aus GA zu importieren?

Wir empfehlen dringend, Ihre Daten zu importieren, nachdem Sie unsere App erfolgreich auf Ihrer Webseite installiert und mindestens einen Besuch mit uns aufgezeichnet haben, um Kontinuität zu gewährleisten.

Wenn Sie bereits Daten mit unserer App erfasst haben und mit der Synchronisierung beginnen möchten, holt der Importer die Daten bis zum ersten von uns erfassten Besuch. Auf diese Weise wird eine harmonische Zusammenführung mit den von Ihnen bereits erfassten Daten gewährleistet.

Sie können auch Ihre Google Analytics (GA)-Daten importieren, wenn Sie Ihre Webseite zu Ihrem TWIPLA-Konto hinzufügen, auch wenn noch nichts von unserer App aufgezeichnet wurde. Beachten Sie jedoch, dass zwischen dem Start des Imports und der Einbettung unseres Tracking-Codes eine Lücke entstehen kann. Das liegt daran, dass der Importer bis zu dem Moment, in dem Sie ihn starten, Daten liefert und die Daten zwischen diesen beiden Zeitpunkten verloren gehen.

Wichtiger Hinweis: Sie können die Daten nur einmal pro Webseite importieren!

Kann ich Daten von 2 verschiedenen GA-Konten in dasselbe TWIPLA-Konto importieren?

Ja, diese Aktion ist möglich. Es ist jedoch wichtig zu beachten, dass der Datenimport nur für verschiedene Webseiten möglich ist, nicht für dieselbe Webseite. Das Importieren ist ein einmaliger Vorgang pro Webseite.

Um Daten einer anderen Webseite aus einem anderen Google Analytics (GA)-Konto zu importieren, entfernen Sie einfach die Berechtigungen aus Ihrem Google-Konto für die TWIPLA-App, die bereits für den Datenimport im vorherigen Konto verwendet wurde.

Was passiert, wenn ich meine Daten zurücksetze, nachdem ich sie von GA importiert habe?

Nachdem Sie Ihre Google Analytics (GA)-Daten in TWIPLA für Ihre Webseite importiert haben, werden sie als TWIPLA-Daten behandelt. Wenn Sie also Ihre TWIPLA-Daten zurücksetzen, werden auch die GA-Daten gelöscht.

Es ist wichtig zu beachten, dass Sie Daten von GA nur einmal pro Webseite importieren können, auch wenn Sie sie danach zurücksetzen.

Um den AppSumo-Plan auf Ihre Webseite anzuwenden, folgen Sie bitte diesen Schritten:

- Loggen Sie sich in Ihre TWIPLA-Konto ein.

- Navigieren Sie zu den Kontoeinstellungen und wählen Sie die Webseite, für die Sie den Plan hinzufügen möchten.

- Klicken Sie auf das Drei-Punkte-Menü-Symbol und wählen Sie dann AppSumo LTD anwenden.

Die Schaltfläche Anwenden ist ein erforderlicher Schritt, da wir Ihnen die Möglichkeit geben möchten, die Webseiten auszuwählen, auf die Sie die Codes anwenden möchten, anstatt das Angebot standardmäßig auf alle Ihre Webseiten anzuwenden.

Hinweis: Um AppSumo LTD auf eine andere Webseite anzuwenden, müssen Sie die aktuelle Webseite, auf die Sie den AppSumo-Plan angewendet haben, löschen, damit Sie die Möglichkeit haben, diesen Slot erneut auf eine andere Webseite anzuwenden. Eine Herabstufung auf kostenfrei ist leider nicht möglich.

Haben Sie irgendwelche laufenden Bug Bounty Programme? Bieten Sie Belohnungen an, wenn wir Ihnen Sicherheitslücken melden?

Leider führen wir im Moment kein Bug Bounty Programm durch.

Was wir stattdessen anbieten können, ist, Ihnen einen Rabatt für den Kauf einer unserer Pläne anzubieten, wenn Sie unsere App auf Ihrer Webseite installiert haben und Sie ein Upgrade wünschen. Wir können Ihnen einen Rabatt von 20% auf Ihren ersten Abrechnungszyklus für eines der ausgewählten Abonnements anbieten.

Kann ich mit TWIPLA Werbeblocker umgehen?

Unsere App kann die Besuche auch dann verfolgen, wenn AdBlocker im Einsatz sind, es sei denn, der Nutzer hat in den Einstellungen des Adblockers (sofern vorhanden) die Option Easy Privacy eingestellt, die jede Tracking-App daran hindert, die Aktivitäten in diesem Browser zu verfolgen. Mehr Informationen dazu, finden Sie im Internet, wenn Sie nach dem Begriff Easy Privacy für AdBlocker suchen.

Wie erkennt man Bots?

Bots verbringen in der Regel nicht viel Zeit auf einer Website - sie suchen lediglich nach Aktualisierungen und ziehen weiter. Die meiste Zeit verhalten sie sich wie Besucher, indem sie dieselbe Seite während verschiedener Sitzungen wiederholt besuchen. Wenn Sie mehrere Besuche auf derselben Seite innerhalb weniger Sekunden feststellen und jeder Besuch eine neue Sitzung erzeugt (auch wenn er von derselben IP-Adresse oder demselben Gerät aus erfolgt), handelt es sich mit ziemlicher Sicherheit um einen Bot.

Die einzige Ausnahme könnte sein, wenn ein echter Benutzer Cookies blockiert hat oder im Inkognito-Modus surft. Aufgrund der Geschwindigkeit und der sich wiederholenden Art dieser Besuche ist es jedoch höchst unwahrscheinlich, dass es sich um menschliches Verhalten handelt.

In unserer App, verwenden wir eine Bibliothek namens CrawlerDetect. CrawlerDetect ist eine Open-Source-PHP-Bibliothek, die weit verbreitet ist, um Web-Crawler und Bots anhand ihrer User-Agent-Strings und anderer HTTP-Header zu identifizieren. Dieses Tool ist besonders nützlich für Website-Besitzer, -Entwickler und -Analysten, die nicht-menschlichen Datenverkehr herausfiltern müssen, um genaue Analysen zu gewährleisten oder um Crawler-spezifische Regeln zu implementieren. Es verwendet die folgende Liste: Crawlers.txt.

Obwohl wir bereits Tausende von Bots herausfiltern, schlüpfen immer noch einige durch, weil sich die User-Agent-Strings ständig ändern. Wir versichern Ihnen, dass wir versuchen werden, unsere Filter zu verbessern und zu sehen, wie wir eine größere Anzahl von Bots ignorieren können, da sie sich ständig ändern.

Bis dahin gibt es einen Workaround, um einige von ihnen manuell anhand ihrer IP-Adressen zu ignorieren. Sie können den Artikel "Warum erhalte ich Besuche aus Ländern, mit denen meine Website nichts zu tun hat?" in unserem Abschnitt über die Funktionsweise der Funktionen lesen oder den Zugang zu einigen Bots blockieren, indem Sie die Datei robot.txt erstellen und einige der wichtigsten Bots ausschließen.

Es kann sein, dass wir in der obigen Liste keine passende Antwort auf Ihre Frage in petto haben.

Wir helfen Ihnen gerne! Kontaktieren Sie uns, wenn Sie keine Antwort auf unserer FAQ-Seite oder im Support-Center finden können.